数据抓取技术在招聘领域的应用日益广泛,企业通过自动化工具从各大招聘平台、企业官网、社交媒体等渠道获取人才信息,以提升招聘效率、降低成本并扩大人才搜索范围,这一过程也涉及法律合规、数据安全及伦理问题,需在合理范围内规范使用。

数据抓取在招聘中的核心应用场景

-

人才库建设

企业通过抓取招聘网站上的公开简历信息(如求职者技能、工作经验、联系方式等),构建自有人才库,快速匹配岗位需求,技术型企业可从GitHub、Stack Overflow等平台抓取开发者的项目经验和技术栈信息,精准定位潜在候选人。 -

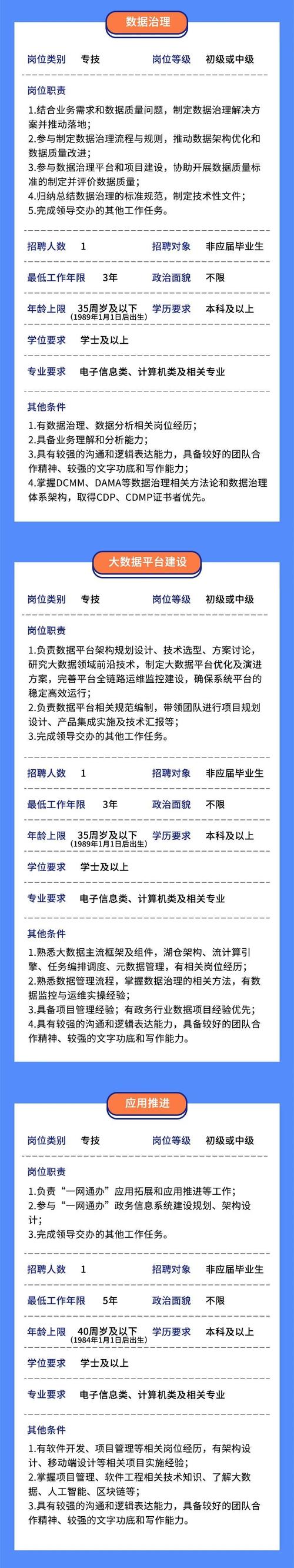

竞品人才分析

HR部门可通过抓取竞争对手的招聘页面,分析其岗位需求、薪资范围及人才画像,为企业制定薪酬策略和招聘计划提供参考,抓取某互联网公司“数据分析师”岗位的JD(职位描述),提炼核心技能要求,调整自身招聘标准。 -

市场薪酬调研

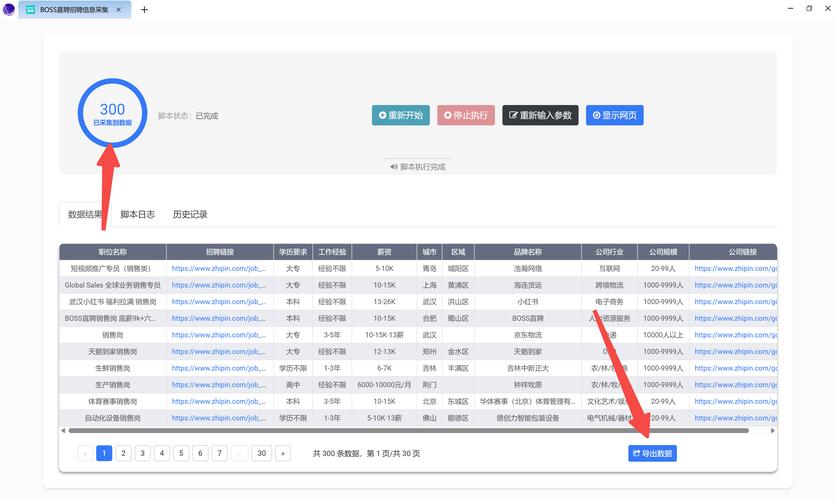

实时抓取各平台发布的薪资数据,结合地区、行业、经验维度生成薪酬报告,通过抓取猎聘、BOSS直聘上“Java工程师”的薪资范围,制作企业内部薪酬竞争力对比表,优化薪酬结构。 -

被动候选人挖掘

针对未主动投递简历的优秀人才,通过抓取LinkedIn、脉脉等职业社交平台的信息,主动触达潜在候选人,抓取某行业高管的职业背景和项目经历,定向发送招聘邀请。 (图片来源网络,侵删)

(图片来源网络,侵删)

数据抓取的技术实现与工具选择

常用技术栈

| 技术类型 | 工具/语言 | 适用场景 |

|---|---|---|

| 静态网页抓取 | Python (BeautifulSoup) | 无需登录的简单页面(如企业官网JD) |

| 动态网页抓取 | Selenium, Playwright | 需交互的动态页面(如登录后的搜索结果) |

| API接口调用 | 八爪鱼、集搜客 | 提供开放接口的平台(如LinkedIn API) |

| 反爬虫应对 | 代理IP、验证码识别、随机延时 | 避免触发平台反爬机制 |

实施步骤

- 目标数据定位:明确需求(如简历、岗位信息),确定抓取字段(如姓名、技能、薪资)。

- 爬虫开发:根据页面类型选择静态或动态抓取方式,编写脚本解析HTML结构。

- 数据清洗:去除重复、无效信息,标准化格式(如统一日期格式、技能分类)。

- 存储与分析:将数据存入MySQL、MongoDB等数据库,通过BI工具生成可视化报告。

法律合规与风险规避

-

遵守平台规则

多数招聘平台(如智联招聘、前程无忧)在用户协议中明确禁止未经授权的数据抓取,违规可能导致IP封禁或法律诉讼,需优先选择提供官方API的平台,或遵守平台的Robots协议(如限定爬取频率、范围)。 -

保护个人隐私

根据《个人信息保护法》,抓取的简历信息需匿名化处理,不得收集与招聘无关的敏感信息(如身份证号、婚姻状况),企业需建立数据安全管理制度,确保数据存储加密、访问权限可控。 -

伦理边界

避免过度抓取或恶意竞争,例如不得用于批量骚扰候选人或倒卖个人信息,建议仅抓取公开信息,且用于企业内部招聘用途。

案例分析:某科技公司人才数据抓取实践

某互联网公司为招聘AI算法工程师,通过以下流程完成数据抓取:

- 目标:收集3个月内发布的AI岗位JD及候选人技能标签。

- 工具:使用Selenium模拟登录BOSS直聘,BeautifulSoup解析岗位详情页。

- 字段:岗位名称、学历要求、薪资、编程语言(Python/Java)、框架(TensorFlow/PyTorch)。

- 结果:抓取500+条有效数据,分析得出“Python+TensorFlow”组合需求占比达72%,据此调整了招聘技能考核重点。

相关问答FAQs

Q1:数据抓取获取的候选人联系方式,是否可以直接用于电话沟通?

A1:不建议直接使用,根据《个人信息保护法》,联系方式属于个人信息,未经候选人明确同意不得用于营销或招聘外用途,企业可通过招聘平台的官方渠道(如站内信)联系候选人,或确保在简历中已授权第三方信息共享。

Q2:如何判断数据抓取行为是否合法?

A2:需同时满足三个条件:① 遵守目标平台的Robots协议和用户协议;② 仅抓取公开信息,不绕过反爬措施(如验证码);③ 数据用途合法且采取必要安全措施,若涉及大规模抓取或敏感信息,建议咨询法律专业人士或通过官方API获取数据。