北京作为中国的科技创新中心,近年来在大数据、人工智能等领域的人才需求持续旺盛,Apache Spark作为分布式计算框架的核心技术,已成为企业数据处理和机器学习场景的重要工具,因此掌握Spark技术的开发工程师和数据科学家在北京的就业市场上备受青睐,以下从招聘需求、技能要求、企业类型、薪资范围及求职建议等方面,详细分析北京地区的Spark相关招聘情况。

北京地区的Spark招聘需求主要集中在互联网、金融、科技服务及传统行业的数字化转型部门,互联网企业如字节跳动、美团、京东等,对Spark工程师的需求量最大,主要用于推荐系统、实时计算、用户行为分析等场景;金融机构如中信证券、工商银行科技子公司等,则侧重利用Spark进行风控建模、交易数据分析及合规审计;科技服务公司如华为、阿里巴巴北京研究院等,需要Spark工程师参与大数据平台的建设与优化;传统行业如能源、零售领域的龙头企业,也在通过Spark技术实现数据中台搭建,推动业务智能化升级,从岗位类型来看,Spark开发工程师、大数据开发工程师(Spark方向)、数据平台架构师、机器学习工程师(Spark MLlib方向)等是主流职位,其中具备实时计算(Structured Streaming/Kafka)和机器学习能力的复合型人才尤为稀缺。

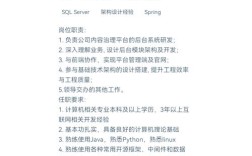

在技能要求方面,企业普遍对候选人的Spark技术深度和工程实践能力有较高标准,核心技能包括:熟练掌握Spark Core、Spark SQL、Spark Streaming、MLlib GraphX等组件的原理与使用,能独立完成分布式数据处理任务;精通Scala或Python(PySpark),具备高性能代码调优能力,熟悉内存管理、任务调度、数据倾斜等问题的解决方案;了解Hadoop、Hive、HBase、Kafka等大数据生态组件的协同工作原理,能基于Spark构建完整的数据处理 pipeline;掌握实时数仓建设、离线批处理、机器学习模型训练等场景的Spark应用实践;熟悉云平台(如阿里云EMR、腾讯云TDSQL、AWS EMR)的大数据服务部署者优先,对于高级岗位,还要求具备分布式系统架构设计能力,能针对业务需求优化Spark集群性能,或结合Flink、Spark Streaming实现流批一体的解决方案,学历方面,本科及以上学历为基本门槛,头部企业更倾向于985/211高校计算机相关专业背景,或有知名互联网公司大数据经验的候选人。

薪资水平方面,北京的Spark岗位薪资在全国处于领先地位,具体受工作经验、技术深度和企业类型影响,初级Spark开发工程师(1-3年经验)年薪通常在20万-35万元,中级工程师(3-5年经验)可达35万-55万元,高级工程师/架构师(5年以上经验)普遍在55万-90万元,部分顶尖人才或管理岗位年薪可突破百万,字节跳动、美团等大厂为吸引人才,常提供高额年终奖(约6-12个月薪资)和股票期权;金融机构的薪资虽略低于互联网大厂,但福利待遇优厚,如补充医疗、企业年金等;创业公司则可能通过股权激励吸引核心技术人才,值得注意的是,掌握Spark实时计算、机器学习及云原生技术(如Kubernetes部署Spark)的候选人,薪资溢价明显,部分岗位薪资较传统Spark开发高出20%-30%。

针对求职者,建议从以下几个方面提升竞争力:夯实技术基础,深入理解Spark的底层架构(如RDD、DAG调度、内存管理),通过实际项目(如构建用户画像系统、实时推荐引擎)积累实战经验;紧跟技术趋势,学习Spark 3.x的新特性(如动态分区裁剪、Adaptive Query Execution)及与Delta Lake、Iceberg等数据湖技术的结合应用;拓展大数据生态技能,掌握Flink、ClickHouse等工具,形成“Spark+其他工具”的技术组合;关注目标企业的业务场景,例如求职互联网公司时可重点准备推荐系统、实时计算相关案例,求职金融企业则需熟悉风控建模、数据安全等合规要求,对于应届生,建议通过参与开源项目(如Apache Spark贡献)、实习或 Kaggle竞赛等方式丰富简历,同时注重算法和编程基础(如Scala、Python、数据结构与算法)的积累。

相关问答FAQs

Q1:北京Spark岗位对学历要求严格吗?非科班出身有机会吗?

A1:北京头部企业(如大厂、金融机构)对学历有一定偏好,本科及以上学历是基本门槛,科班背景(计算机、软件工程、数据科学等)在简历筛选中更具优势,但非科班出身者若具备扎实的技术能力和项目经验,同样有机会获得offer,有候选人通过自学Spark并参与实际项目(如搭建离数仓、完成Kafka+Spark实时数据处理),或通过大数据认证(如CCA175)证明能力,最终成功入职,关键在于能否在面试中展示对Spark核心原理的理解和解决实际问题的能力,部分企业更看重技术实力而非学历背景。

Q2:如何提升Spark岗位的竞争力?有哪些学习资源推荐?

A2:提升竞争力的核心在于“深度+广度+实践”,深度方面,建议精读《Spark权威指南》《Fast Data Apache Spark性能调优》等书籍,掌握源码级调优技巧;广度方面,学习Spark与Flink、Kubernetes等工具的协同应用,了解数据湖(Delta Lake/Iceberg)、实时计算等前沿技术;实践方面,通过GitHub参与开源项目或自行搭建完整的数据处理 pipeline(如从数据采集到实时分析的可视化系统),学习资源推荐:官方文档(spark.apache.org)、Coursera上的“Big Data Analysis with Scala and Spark”课程、B站技术博主(如“阿里云开发者”)的实战教程,以及参加北京地区的Spark技术沙龙(如Meetup)积累行业人脉。