命令行中的数据科学是一个日益受到重视的领域,它将强大的命令行工具与数据科学工作流相结合,使数据科学家能够更高效地处理、分析和可视化数据,与依赖图形用户界面(GUI)的传统方法相比,命令行工具通常具有轻量级、可重复性强、自动化程度高以及资源消耗低等优势,本文将详细介绍命令行在数据科学各个阶段的应用,包括数据获取、清洗、转换、分析、建模以及结果可视化,并通过表格对比常用工具的特点,最后以FAQs形式解答常见疑问。

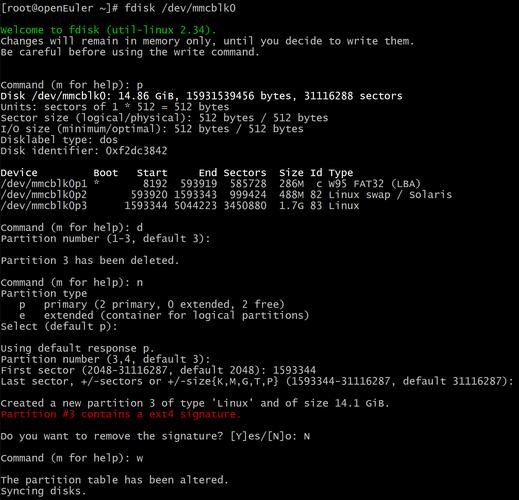

在数据获取阶段,命令行工具能够快速从各种数据源提取数据。curl和wget可以用于从网页或API下载数据,而sqlcmd或mysql命令行工具则允许直接与数据库交互执行查询并导出结果,对于大规模数据集,rsync可以实现高效的增量数据同步,这些工具的灵活性使得数据获取过程可以脚本化,便于定期自动更新数据源,避免了手动下载的繁琐和潜在错误。

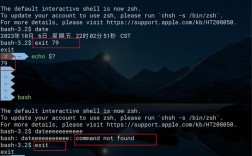

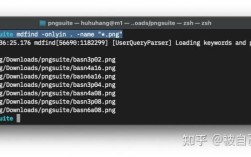

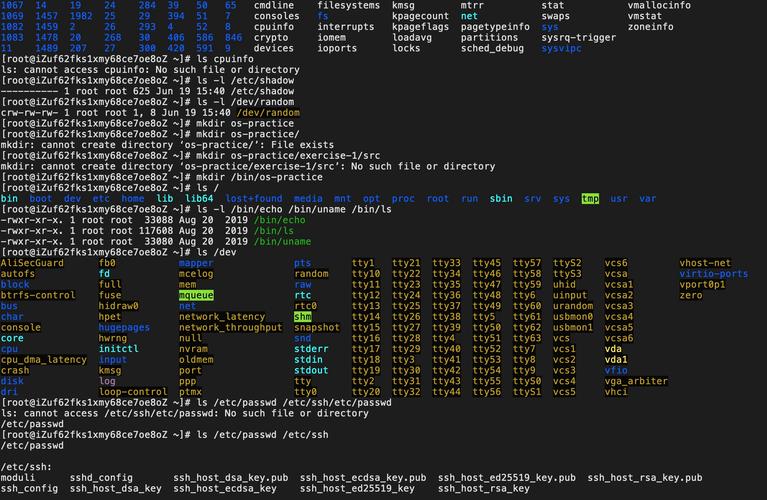

数据清洗和转换是数据科学中最耗时但至关重要的环节,命令行工具在此展现出强大威力。awk和sed是文本处理的利器,awk擅长按列处理和计算,例如awk '{print $1, $3}'可以提取文件的第一列和第三列;sed则用于文本替换和删除,如sed 's/old/new/g'可将所有“old”替换为“new”。cut、sort、uniq和join等命令提供了基础的列提取、排序、去重和合并功能,对于结构化数据,csvkit套件中的csvcut、csvsort和csvjoin等命令专门针对CSV格式进行了优化,操作更为直观。jq是处理JSON数据的神器,可以通过类似jq '.users[].name'的语法轻松解析和提取JSON字段,这些工具通过管道()连接,可以构建复杂的数据处理流水线,例如cat data.csv | csvcut -c 1,3 | awk -F',' '{print $1, $2*2}' | sort | uniq,实现了从原始数据到清洗后数据的无缝流转。

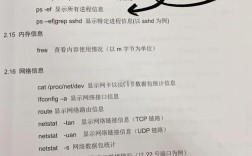

在数据分析和探索阶段,命令行工具同样能胜任。datamash是一个命令行统计工具,可以快速计算列的均值、中位数、标准差等统计量,对于更复杂的分析,R或Python可以通过命令行执行脚本,例如Rscript --vanilla -e "data <- read.csv('data.csv'); summary(data)"可以直接在终端输出数据摘要。pandas的-c选项或ipython的--pylab模式也允许在命令行中快速进行交互式数据分析。gnuplot或ploticus等工具可以直接在命令行生成图表,实现数据的初步可视化。

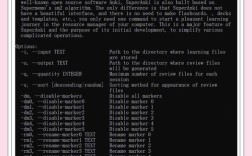

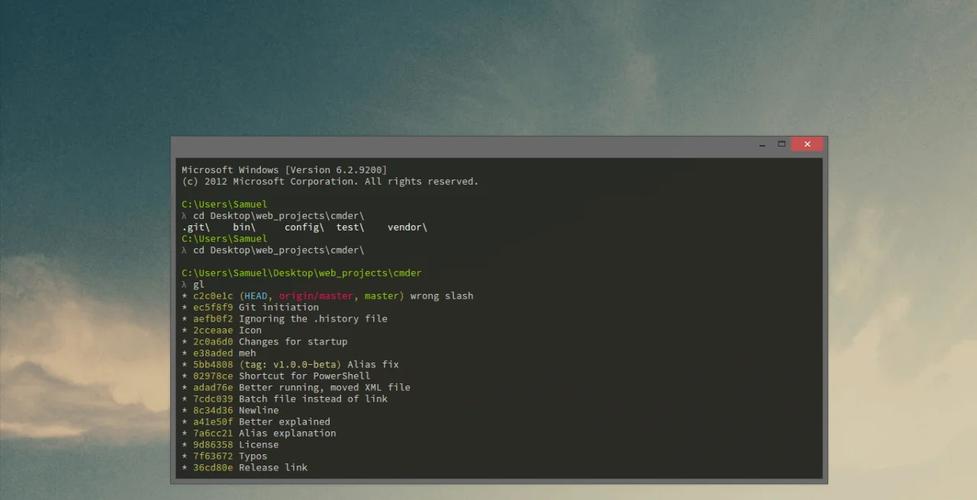

数据建模阶段,命令行工具更多是作为现有建模流程的辅助或自动化手段。scikit-learn的模型可以通过Python脚本训练,然后使用joblib或pickle保存模型,最后通过命令行加载模型对新数据进行预测,对于机器学习流水线,makefile或snakemake等工具可以定义依赖关系和执行步骤,实现模型训练、评估和部署的自动化。xgboost或lightgbm等框架本身提供了命令行接口,允许直接通过命令训练模型,如xgboost train.txt model.out。

结果可视化和报告生成方面,命令行工具可以生成图表并嵌入到报告中。matplotlib或seaborn的Python脚本可以在命令行执行并保存图片为PNG或PDF格式,对于更动态的报告,Jupyter Notebook可以通过命令行启动,并将输出转换为HTML或Markdown文件。pandoc是一个强大的文档转换工具,可以将Markdown、HTML或LaTeX文件转换为多种格式,非常适合将命令行分析结果整合成最终报告。

以下表格总结了命令行中常用的数据科学工具及其主要功能:

| 工具名称 | 主要功能 | 适用场景 |

|---|---|---|

curl/wget |

下载数据 | 从URL获取文件或API响应 |

awk/sed |

文本处理、替换、提取 | 非结构化或半结构化文本处理 |

cut/sort/uniq |

列提取、排序、去重 | 简单表格数据处理 |

csvkit |

CSV文件的切割、合并、转换、统计 | 结构化CSV数据操作 |

jq |

JSON数据的解析、提取、转换 | 处理API返回的JSON数据 |

datamash |

基础统计计算(均值、中位数、计数等) | 快速数据探索和统计摘要 |

R/Python |

高级数据分析、统计建模、可视化 | 复杂数据科学任务 |

gnuplot |

命令行绘图 | 生成科学图表 |

xgboost |

梯度提升决策树模型的训练和预测 | 机器学习建模 |

pandoc |

文档格式转换(Markdown到HTML/PDF等) | 报告生成和文档整合 |

命令行中的数据科学虽然功能强大,但也存在一定的学习曲线,尤其是对于习惯了GUI工具的用户,以下是一些常见问题的解答:

FAQs

问题1:命令行工具相比GUI工具(如Excel、Pandas DataFrame)在数据清洗方面有哪些优势和劣势?

解答:优势方面,命令行工具具有极高的可重复性,通过脚本化的命令,可以确保每次数据处理步骤完全一致,便于版本控制和协作;命令行工具处理大规模文本文件通常更高效,资源消耗更低,尤其适合处理超过内存大小的文件;命令行工具通过管道连接,可以灵活组合多个工具实现复杂处理流程,无需编写大量代码;命令行工具轻量级,无需安装庞大的软件,通常系统自带或通过包管理器快速安装,劣势方面,对于初学者,命令行工具的学习曲线较陡峭,需要记忆命令语法和选项;命令行处理数据时可视化反馈不足,不如GUI工具那样直观地查看数据中间状态;对于非结构化或复杂格式的数据,命令行处理可能需要编写更复杂的脚本,不如GUI的拖拽操作便捷;命令行工具的错误排查可能相对困难,一个小小的语法错误就可能导致整个处理流程失败。

问题2:如何将命令行数据分析流程与Python/R等编程语言结合,以发挥各自的优势?

解答:将命令行与编程语言结合是数据科学工作流中的常见最佳实践,具体方法包括:利用命令行工具进行数据预处理,如使用csvkit或awk对原始数据进行清洗、筛选和格式转换,生成结构化的中间文件(如CSV、TSV),这一步可以充分利用命令行处理文本的高效性;在Python/R中读取这些中间文件进行深度分析和建模,例如使用Python的pandas库读取CSV文件,进行数据框操作、统计分析或调用scikit-learn进行机器学习建模;将Python/R的分析结果通过命令行工具进行后处理或可视化,例如使用matplotlib生成图表并保存为图片,然后使用convert(ImageMagick)进行图片处理,或使用pandoc将Markdown格式的分析报告转换为PDF;通过脚本(如Bash脚本或Python脚本)将整个流程串联起来,实现从数据获取到最终报告生成的自动化,例如在Bash脚本中调用python script.py执行Python代码,或使用Python的subprocess模块执行命令行命令,这种结合方式既能利用命令行处理原始数据的速度和灵活性,又能发挥Python/R在复杂分析和建模方面的强大能力,形成高效、可重复的数据科学流水线。