的重要手段,广泛应用于新闻聚合、舆情监控、市场分析等领域,要高效、合规地完成这一任务,需结合技术工具、流程设计和法律伦理考量,以下从准备工作、技术实现、优化维护及注意事项等方面展开详细说明。

明确需求与准备工作

在开始抓取前,需先明确目标:需要抓取哪些网站?关注哪些板块(如新闻列表、公告栏、动态更新区)?更新频率要求多高(实时、每小时、每日)?数据格式需要什么(文本、图片、链接、发布时间)?这些问题的答案将直接影响后续工具选择和方案设计。

准备工作包括:

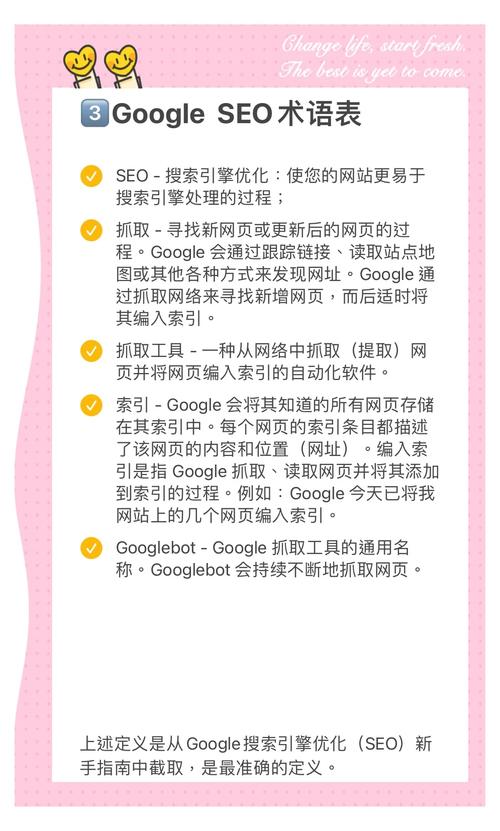

- 目标网站分析:查看目标网站的robots.txt文件(通常位于域名根目录,如

example.com/robots.txt),了解其允许抓取的路径和禁止访问的区域;检查网站是否使用动态加载(如Ajax、React/Vue前端渲染),判断需模拟浏览器行为还是直接请求API。 - 工具与资源准备:根据技术能力选择工具——编程语言(Python常用库如Requests、BeautifulSoup、Scrapy)、可视化工具(如Octoparse、八爪鱼)或浏览器插件(如Web Scraper);若需高频抓取,需准备代理IP池和云服务器资源,避免本地IP被封禁。

技术实现:常见抓取方法与流程

(一)静态网页抓取(直接HTML解析)为静态加载(HTML直接包含所有数据),可通过以下步骤实现:

- 发送HTTP请求:使用Python的

requests库模拟浏览器访问目标页面,设置请求头(如User-Agent、Referer)模拟正常用户,避免被反爬机制拦截,示例代码:import requests headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36'} response = requests.get('https://example.com/news', headers=headers) response.encoding = 'utf-8' # 设置编码避免乱码 - 解析HTML内容:用

BeautifulSoup或lxml解析HTML,通过CSS选择器或XPath定位目标数据(如新闻标题、链接、时间),示例:from bs4 import BeautifulSoup soup = BeautifulSoup(response.text, 'html.parser') news_list = soup.select('.news-item') # 假设新闻块类名为news-item for news in news_list: title = news.select_one('.title').text.strip() time = news.select_one('.time').text.strip() print(f"标题: {title}, 时间: {time}")

(二)动态网页抓取(模拟浏览器渲染)

若网站通过JavaScript动态加载数据(如滚动加载、点击“加载更多”),需使用无头浏览器(如Selenium、Playwright)模拟用户操作,以Selenium为例:

-

配置浏览器驱动:下载对应浏览器的驱动(如ChromeDriver),并配置环境变量;或使用

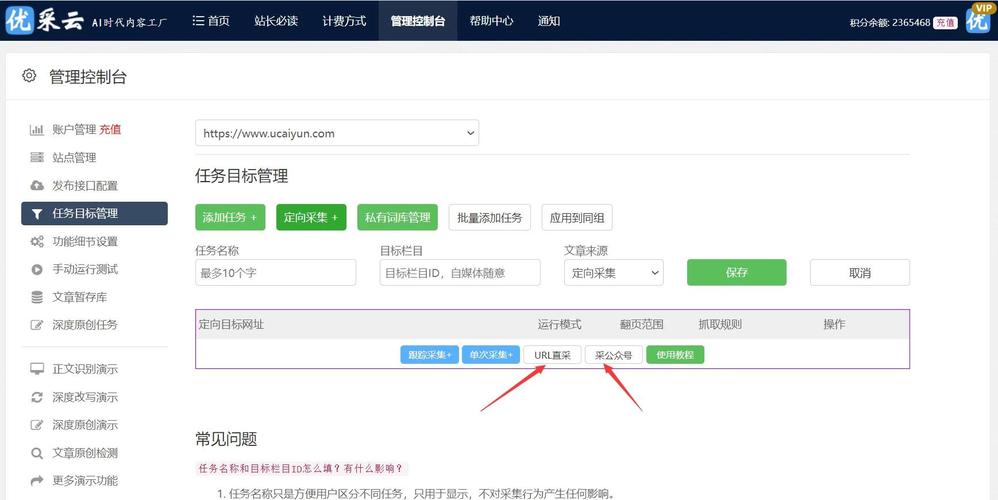

webdriver-manager库自动管理驱动。 (图片来源网络,侵删)

(图片来源网络,侵删) -

模拟操作与获取数据:打开页面后,等待动态加载完成,再提取数据,示例:

from selenium import webdriver from selenium.webdriver.common.by import By from selenium.webdriver.support.ui import WebDriverWait from selenium.webdriver.support import expected_conditions as EC driver = webdriver.Chrome() # 需提前安装Chrome浏览器和对应驱动 driver.get('https://example.com/dynamic-news') # 等待新闻列表加载完成(最多10秒) news_list = WebDriverWait(driver, 10).until( EC.presence_of_all_elements_located((By.CLASS_NAME, 'news-item')) ) for news in news_list: title = news.find_element(By.CLASS_NAME, 'title').text print(title) driver.quit()

(三)API接口抓取(高效稳定)

部分网站提供公开API(如新闻API、RSS订阅),可直接调用接口获取结构化数据,效率高且不易触发反爬,通过requests调用JSON接口:

import requests

api_url = 'https://example.com/api/news?page=1&limit=10'

response = requests.get(api_url, headers=headers)

data = response.json() # 解析JSON数据

for item in data['results']:

print(item['title'], item['publish_time'])

数据存储与更新机制

抓取到的数据需存储以便后续使用,常见存储方式及适用场景如下:

| 存储方式 | 特点 | 适用场景 |

|---|---|---|

| 文本文件(CSV/JSON) | 简单易用,适合小规模数据;查询效率低,不支持复杂操作。 | 临时存储、数据量小的测试 |

| 关系型数据库(MySQL/PostgreSQL) | 支持结构化数据、事务处理,适合复杂查询和关联分析;需设计表结构。 | 长期存储、需高频查询的业务 |

| 非关系型数据库(MongoDB/Redis) | 灵活存储非结构化数据,读写速度快;适合高并发和实时场景。 | 日志存储、实时消息推送 |

| 云存储(AWS S3/阿里云OSS) | 可扩展性强,适合大规模数据备份和分布式访问;需额外配置访问权限。 | 跨平台数据共享、大数据分析 |

更新机制设计:

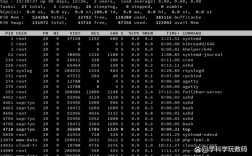

- 定时任务:使用

APScheduler(Python库)或系统级定时工具(如Linux的cron、Windows的“任务计划程序”),按设定间隔(如每小时)执行抓取脚本。 - 增量更新:记录已抓取数据的唯一标识(如新闻ID、发布时间),每次抓取时只获取新增或修改的数据,避免重复处理。

反爬应对与合规性处理

网站为防止恶意抓取,常设置反爬机制,需合理应对:

- IP限制:通过代理IP池轮换访问(如使用

requests的proxies参数或Scrapy的中间件),避免单一IP高频请求。 - 验证码/登录验证:对于需登录的网站,可使用Selenium模拟登录流程;或对接第三方打码平台(如打码兔、超级鹰)识别验证码。

- 请求频率控制:在脚本中添加随机延迟(如

time.sleep(random.uniform(1, 3))),模仿人类操作节奏。 - User-Agent伪装:维护一个User-Agent列表,每次请求随机选择,避免被识别为爬虫。

合规性注意事项:

- 遵守

robots.txt规则,不抓取禁止访问的路径; - 尊重网站版权,仅抓取公开信息,不用于商业用途;

- 避免对服务器造成过大压力(如控制请求频率),必要时联系网站管理员获取授权。

FAQs

问题1:抓取网站数据时遇到403错误怎么办?

解答:403错误表示服务器拒绝访问,通常是因为反爬机制识别了爬虫行为,应对方法包括:① 修改请求头,添加常见的User-Agent(如Chrome、Firefox的UA);② 使用代理IP更换访问地址;③ 降低请求频率,在脚本中添加延迟;④ 检查是否触发了验证码,可通过Selenium模拟人工操作或对接打码平台解决。

问题2:如何高效抓取动态加载的网页内容?

解答:动态加载的网页需通过无头浏览器模拟用户行为,具体步骤:① 安装Selenium或Playwright库及对应浏览器驱动;② 编写脚本打开目标页面,使用显式等待(如WebDriverWait)等待动态元素加载完成;③ 定位并提取数据;④ 抓取完成后关闭浏览器释放资源,可分析网页的Network请求,找到数据加载的API接口,直接调用接口获取数据(效率更高)。