添加语音搜索引擎功能是提升应用或网站用户体验的重要手段,尤其适合移动端、智能家居、车载系统等场景,以下从技术选型、实现步骤、优化方向及注意事项等方面详细说明具体操作方法。

明确需求与技术选型

在开始开发前,需明确语音搜索的核心功能需求,例如是否需要实时语音识别、语义理解、多语言支持、离线模式等,根据需求选择合适的技术方案,常见的技术路径包括:

- 第三方API服务:适合快速集成,如百度语音识别、阿里云智能语音、科大讯飞语音云、Google Speech-to-Text、Azure Speech Service等,这类服务提供成熟的语音识别、自然语言处理(NLP)能力,支持多种语言和方言,通常按调用量收费。

- 开源框架:适合需要定制化或控制成本的场景,如Kaldi、SpeechRecognition(Python库)、Vosk(离线语音识别)等,开源框架需自行训练模型或处理服务器部署,灵活性高但技术门槛较高。

- 混合方案:结合第三方API与开源工具,例如用开源工具进行前端语音采集,用第三方API进行云端识别,兼顾性能与成本。

实现步骤详解

前端语音采集与预处理

- 权限申请:在Web或App中,需通过浏览器API(如

navigator.mediaDevices.getUserMedia)或移动端SDK获取麦克风权限,确保用户授权后才能启动语音采集。 - 音频流处理:实时采集音频数据,进行降噪、回声消除、增益控制等预处理,使用Web Audio API的

AudioContext节点对音频进行滤波,提升识别准确率。 - 语音活动检测(VAD):通过算法检测有效语音片段,避免静音或环境噪音的干扰,减少无效数据传输,可使用开源VAD工具(如WebRTC VAD)或第三方API内置功能。

语音识别转文本

- 实时识别模式:适用于对话类场景,将音频流分片(如每100ms发送一段)实时传输至服务器,返回即时文本结果,需注意分片大小与延迟的平衡,避免因分片过小导致识别错误。

- 非实时识别模式:适用于搜索指令等场景,用户说完后点击结束,将完整音频文件上传至服务器进行识别,支持更长音频,但延迟较高。

以百度语音API为例,前端集成步骤如下:

// 示例:使用百度Web SDK进行实时识别

const speech = bdsw.event.getAsr();

speech.start({

dev_pid: 80001, // 中文普通话模型ID

callback: (res) => {

console.log('识别结果:', res.result);

}

});

语义理解与搜索逻辑

- 关键词提取:对识别的文本进行分词、去除停用词,提取核心关键词,使用jieba(中文)、NLTK(英文)等工具。

- 意图识别:通过NLP模型判断用户意图(如“查询天气”“播放音乐”),可使用预训练模型(如BERT、LSTM)或第三方NLP服务(如百度NLP、Google Dialogflow)。

- 搜索结果处理:根据意图和关键词调用后端搜索引擎(如Elasticsearch、Solr)或数据库,返回结构化数据,并按相关性排序。

结果展示与交互

- 文本展示:将搜索结果以列表、卡片等形式展示,高亮匹配关键词。

- 语音反馈:可选功能,通过TTS(文本转语音)将结果语音播报,提升交互体验,使用百度TTS API或浏览器内置

SpeechSynthesis。 - 错误处理:针对识别错误(如“订机票”误识别为“定机票”),提供手动修正入口,并收集错误数据用于模型优化。

优化方向

-

准确率提升:

- 训练领域定制模型:若应用场景专业术语较多(如医疗、法律),可通过第三方API提供的数据标注服务训练领域模型。

- 上下文关联:结合对话历史修正识别结果,例如用户连续说“明天”“上海”,可推断为“明天上海的天气”。

-

性能优化:

(图片来源网络,侵删)

(图片来源网络,侵删)- 离线识别:对常用指令(如“打开首页”)支持本地识别,减少网络延迟。

- 音频压缩:采用Opus等高效音频编码格式,降低传输带宽消耗。

-

多端适配:

- 移动端:使用原生SDK(如Android的SpeechRecognizer、iOS的SFSpeechRecognizer)优化兼容性。

- 智能家居:通过麦克风阵列技术实现远场语音识别,抗噪能力更强。

注意事项

- 隐私合规:需明确告知用户语音数据用途,提供数据删除选项,符合GDPR、《个人信息保护法》等法规。

- 网络适应性:弱网环境下需设计断点续传机制,或提示用户检查网络连接。

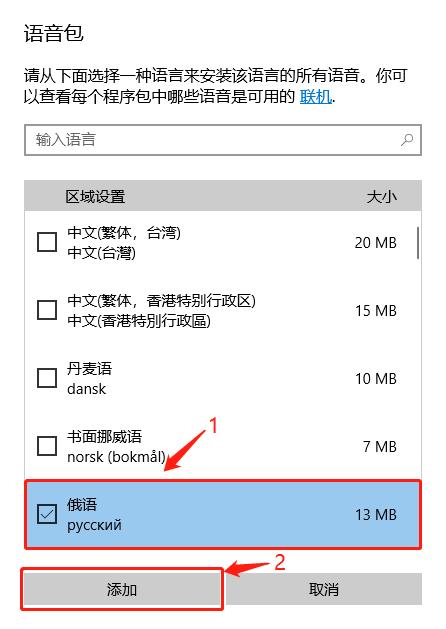

- 多语言支持:若面向全球用户,需支持多语言混合识别(如中英文切换),并注意方言口音差异。

技术方案对比(第三方API)

| 服务商 | 支持语言 | 实时识别 | 离线模式 | 计费方式 | 优势 |

|---|---|---|---|---|---|

| 百度语音 | 中文多方言 | 是 | 部分 | 按调用量付费 | 中文优化好,生态完善 |

| 科大讯飞 | 20+语言 | 是 | 是 | 按功能模块收费 | 教育医疗领域模型成熟 |

| Google Cloud | 120+语言 | 是 | 否 | 免费额度+超量付费 | 多语言支持全,文档丰富 |

| Azure Speech | 95+语言 | 是 | 是 | 按分钟/字符付费 | 企业级安全,集成度高 |

相关问答FAQs

Q1: 语音搜索识别准确率低,如何优化?

A: 可通过以下方式提升:1)优化音频采集环境,降低背景噪音;2)使用领域定制模型,如电商场景可训练商品名称相关词汇;3)结合上下文语义修正,例如通过用户历史搜索记录推断意图;4)启用端点检测(VAD),避免无效音频片段干扰。

Q2: 如何实现离线语音搜索功能?

A: 离线语音搜索需采用本地识别引擎,步骤如下:1)选择支持离线的开源工具(如Vosk)或厂商SDK(如科大讯飞离线引擎);2)下载对应语言的语音模型文件(如中文模型约200MB-500MB);3)在设备端部署模型,通过麦克风采集音频后本地调用识别接口;4)结果返回后与本地搜索引擎或数据库匹配,注意离线模型通常体积较大,且准确率略低于云端方案。