在Hadoop生态系统中,下载是部署和使用Hadoop的第一步,正确的下载命令和流程能够确保用户获取到稳定且功能完善的版本,Hadoop作为开源的分布式存储与计算框架,其官方提供了多种下载方式,包括通过Apache官网直接下载、使用wget或curl命令行工具下载,以及通过Git克隆源码编译等,本文将详细介绍不同场景下的Hadoop下载命令,并辅以操作说明和注意事项,帮助用户顺利完成下载过程。

通过Apache官网直接下载

Apache Hadoop的官方下载地址为https://hadoop.apache.org/releases.html,该页面列出了所有稳定版本和候选版本,用户可以通过浏览器访问页面,选择需要的版本(如最新的稳定版3.3.6),然后点击“binary”链接下载预编译的二进制包,对于习惯命令行操作的用户,可以结合wget或curl工具直接在终端中下载,

wget https://archive.apache.org/dist/hadoop/core/hadoop-3.3.6/hadoop-3.3.6.tar.gz

或

curl -O https://archive.apache.org/dist/hadoop/core/hadoop-3.3.6/hadoop-3.3.6.tar.gz

上述命令会直接将压缩包保存到当前目录,若需指定保存路径,可使用-P参数(如wget -P /path/to/save),下载过程中,建议用户校验文件的完整性,通过SHA-512或MD5值验证文件是否损坏,

sha512sum hadoop-3.3.6.tar.gz

将输出结果与官网提供的校验值对比,确保一致。

通过Git克隆源码并编译

对于需要定制化开发或研究Hadoop源码的用户,可以通过Git克隆官方仓库,自行编译源码,克隆命令如下:

git clone https://github.com/apache/hadoop.git

克隆完成后,切换到指定版本分支(如branch-3.3),然后执行编译命令,编译前需确保系统已安装Java JDK(建议JDK 8或11)、Maven和CMake等依赖工具,编译过程如下:

cd hadoop git checkout branch-3.3 mvn clean package -DskipTests -Pdist -Dmaven.javadoc.skip=true

编译成功后,生成的二进制包位于hadoop-dist/target/目录下,包含hadoop-x.x.x.tar.gz文件,这种方式适用于需要修改源码或参与社区贡献的场景,但编译耗时较长,对系统环境要求较高。

使用包管理工具下载

部分Linux发行版(如Ubuntu、CentOS)提供了Hadoop的包管理安装方式,但需注意官方包可能非最新版本,以Ubuntu为例,可通过APT安装:

sudo apt update sudo apt install hadoop

CentOS系统则可以使用YUM:

sudo yum install hadoop

包管理工具安装的优势是自动处理依赖关系,但灵活性较低,且版本可能滞后于官方最新版,若需指定版本,可通过第三方仓库(如EPEL)或手动下载RPM/DEB包安装。

下载后的解压与环境配置

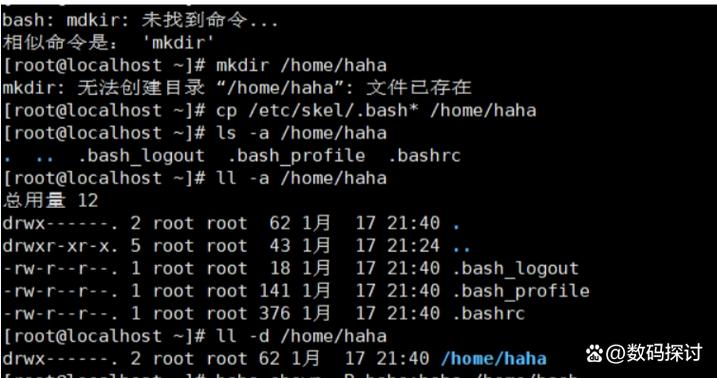

下载完成后,需解压压缩包并配置环境变量,以二进制包为例:

tar -xzvf hadoop-3.3.6.tar.gz -C /usr/local/

解压后,进入Hadoop目录,编辑etc/hadoop/hadoop-env.sh文件,配置JAVA_HOME路径:

export JAVA_HOME=/path/to/java

在系统环境变量中添加Hadoop路径:

export HADOOP_HOME=/usr/local/hadoop-3.3.6 export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

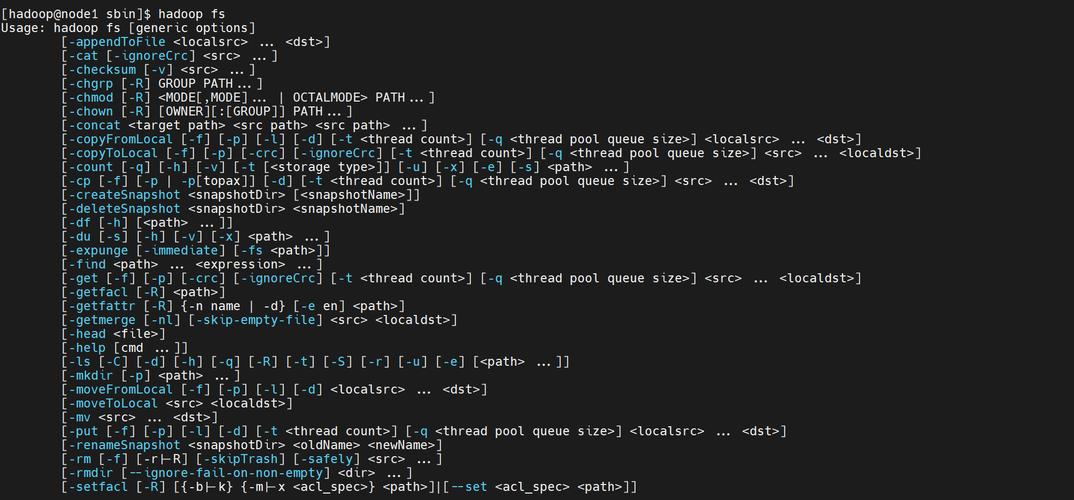

配置完成后,可通过hadoop version命令验证安装是否成功。

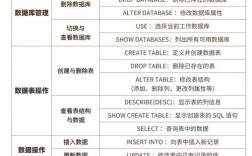

不同下载方式的对比

为帮助用户选择合适的下载方式,以下从版本、依赖、灵活性等方面进行对比:

| 下载方式 | 版本选择 | 依赖环境 | 灵活性 | 适用场景 |

|---|---|---|---|---|

| 官网二进制下载 | 最新稳定版 | 仅Java JDK | 中等 | 生产环境快速部署 |

| Git源码编译 | 任意版本/分支 | JDK、Maven等 | 高 | 开发、研究、定制化 |

| 包管理工具 | 系统默认版本 | 系统自带依赖 | 低 | 测试环境、快速体验 |

常见问题与注意事项

- 下载速度慢:由于Apache服务器可能存在访问延迟,建议使用国内镜像源(如清华大学开源软件镜像站)或开启多线程下载工具(如

axel)加速。 - 版本兼容性:Hadoop版本需与HBase、Hive等组件兼容,建议查阅官方兼容性文档,避免版本冲突。

相关问答FAQs

Q1: 如何验证下载的Hadoop文件是否损坏?

A1: 可通过校验和验证,下载完成后,使用sha512sum命令生成文件的哈希值,与官网提供的SHA-512值对比,若一致则文件完整,否则需重新下载。

sha512sum hadoop-3.3.6.tar.gz

Q2: 下载Hadoop时遇到“Connection refused”错误如何解决?

A2: 该错误通常由网络问题或防火墙设置导致,可尝试切换镜像源(如使用https://mirrors.tuna.tsinghua.edu.cn/apache/hadoop/),或检查本地网络代理配置,若使用公司网络,需确认是否开放了Apache服务器的访问权限。