HDFS put命令是Hadoop分布式文件系统中最基础也是最常用的命令之一,其主要功能是将本地文件系统中的文件或目录上传至HDFS的指定路径,该命令属于HDFS shell操作的一部分,通过调用HDFS的Java API实现文件传输,适用于大数据场景下的数据导入、备份和迁移等任务,下面将从命令语法、功能特性、使用场景及注意事项等方面进行详细说明。

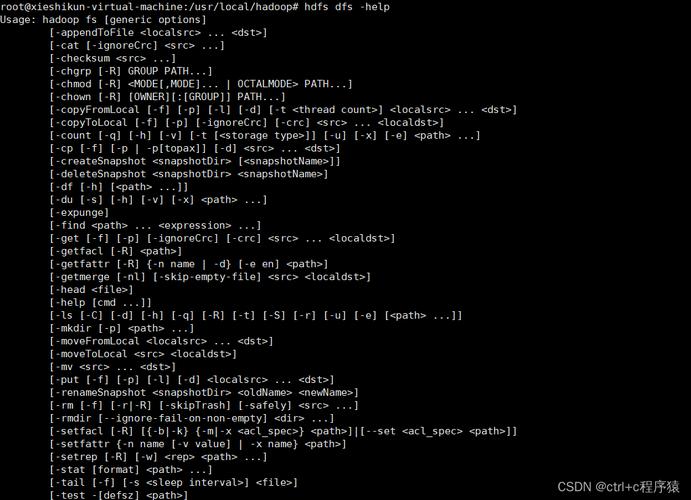

命令语法与基本用法

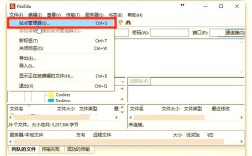

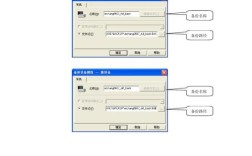

HDFS put命令的基本语法结构为:hdfs dfs -put [local_src] [hdfs_dest]。local_src表示本地文件系统中的源文件或目录路径,支持通配符(如、)进行批量操作;hdfs_dest表示目标HDFS路径,若目标路径已存在同名文件,操作会失败(除非使用-f选项强制覆盖),将本地文件/home/user/data.txt上传至HDFS的/input目录,可执行命令:hdfs dfs -put /home/user/data.txt /input/;若上传整个目录,需添加-r(递归)选项,如hdfs dfs -put -r /home/user/local_dir /hdfs/remote_dir。

核心功能特性

- 递归上传:通过

-r选项,可上传包含子目录和文件的整个目录结构,适用于大数据集的批量迁移。 - 强制覆盖:默认情况下,若目标文件已存在,put命令会报错,使用

-f选项可覆盖现有文件,但需注意数据一致性,避免意外覆盖重要文件。 - 进度显示:上传大文件时,命令行会实时显示传输进度(如

Bytes written: 123MB/500MB),方便监控任务状态。 - 权限与属性保留:上传过程中,文件的权限(如

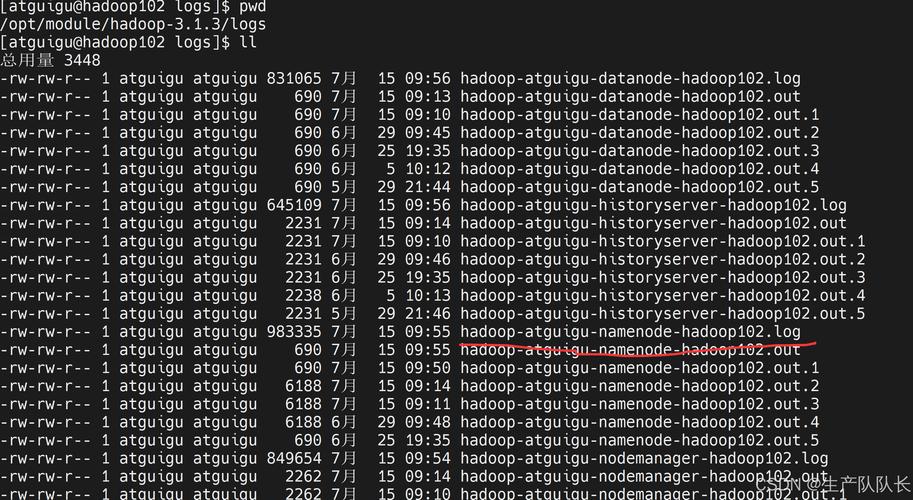

rw-r--r--)和所有者信息会保留,但HDFS的块大小(默认128MB/256MB)和副本数(默认3)由集群配置决定,不会继承本地文件系统的块设置。

使用场景与注意事项

典型场景:

- 数据导入:将本地生成的日志、CSV等文件上传至HDFS,供MapReduce、Spark等计算框架处理。

- 备份迁移:将本地数据备份至HDFS分布式存储,利用HDFS的容错机制保障数据安全。

- 临时文件上传:在数据分析过程中,将临时生成的中间文件上传至HDFS供后续任务调用。

注意事项:

- 网络与性能:上传大文件时,需确保网络稳定,且HDFS集群NameNode和DataNode负载正常,若文件过大(如超过100GB),建议分块上传或使用

distcp工具进行分布式复制。 - 权限问题:执行put命令的用户需对目标HDFS路径具有写权限,否则会报

Permission denied错误。 - 磁盘空间:上传前需检查HDFS目标路径的剩余空间,避免因空间不足导致上传失败。

常见错误与解决方法

| 错误类型 | 原因 | 解决方案 |

|---|---|---|

FileExistsException |

目标文件已存在 | 使用-f选项覆盖,或修改目标路径 |

Permission denied |

用户无权限访问目标路径 | 使用hdfs dfs -chmod修改权限,或切换至有权限的用户 |

No such file or directory |

本地源文件路径错误 | 检查本地文件是否存在,路径是否拼写正确 |

相关问答FAQs

Q1: HDFS put命令能否上传空文件?

A1: 可以,HDFS put命令支持上传空文件,上传后HDFS中会生成一个大小为0的文件,其权限和修改时间会与本地文件保持一致,但需注意,空文件在HDFS中不占用实际存储空间(因为HDFS不存储空块),但会占用文件系统元数据空间。

Q2: 如何验证HDFS put命令是否成功上传文件?

A2: 上传完成后,可通过以下方式验证:

- 使用

hdfs dfs -ls [hdfs_dest]查看目标路径下是否存在上传的文件,并检查文件大小是否与本地一致。 - 使用

hdfs dfs -checksum [hdfs_dest]计算文件的校验和,与本地文件的校验和对比(如使用md5sum命令),确保数据完整性无误。 - 若文件较大,可通过

hdfs dfs -cat [hdfs_dest] | head -n 5查看文件前几行内容,确认数据内容正确。