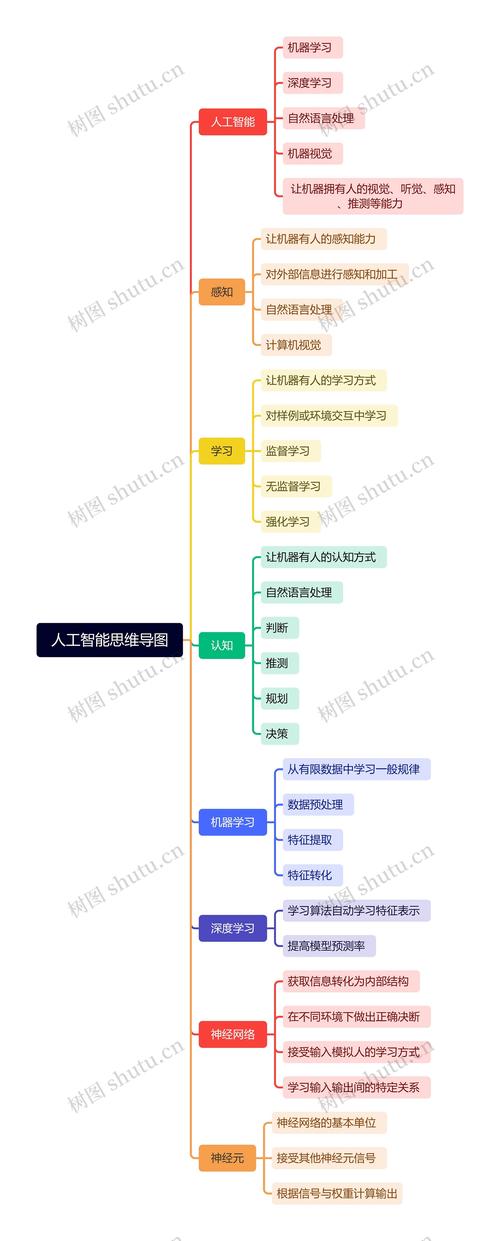

设计开发人工智能是一个系统性工程,需要跨学科协作和全流程规划,首先需明确问题定义与目标拆解,这是整个项目的基石,要清晰界定AI系统需要解决的具体问题,例如是图像分类、自然语言处理还是预测分析,同时量化成功指标,如准确率、响应时间或成本降低幅度,这一阶段需与技术团队、业务方共同对齐需求,避免后续开发偏离方向。

接下来是数据准备与处理,这是AI模型性能的核心保障,数据来源需多样化,包括公开数据集、企业内部数据或第三方合作数据,同时要求数据具备代表性和高质量,数据采集后需进行预处理,包括数据清洗(去除噪声、填补缺失值)、数据标注(监督学习需人工标注标签)、数据增强(通过旋转、裁剪等方式扩充数据量)以及数据标准化(统一量纲),对于不同类型的数据,需采用不同的处理策略,如下表所示:

| 数据类型 | 处理方法 | 常用工具 |

|---|---|---|

| 结构化数据 | 缺失值填充、异常值检测、特征编码 | Pandas、Scikit-learn |

| 图像数据 | 图像归一化、数据增强、尺寸统一 | OpenCV、Albumentations |

| 文本数据 | 分词、去停用词、词向量化 | NLTK、SpaCy、Gensim |

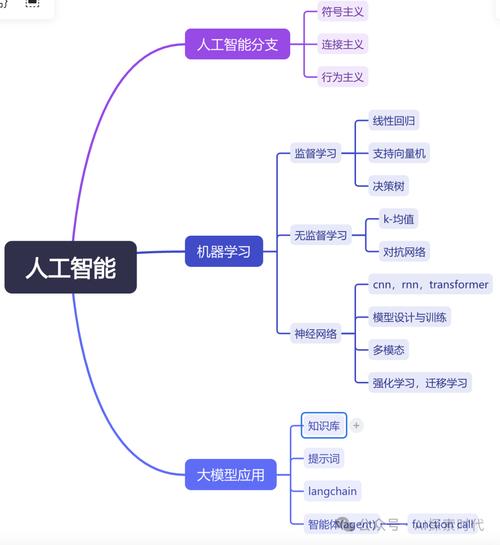

完成数据准备后,进入模型选择与训练阶段,需根据任务类型选择合适的算法,例如分类任务可选用逻辑回归、支持向量机或深度学习模型(如CNN),序列任务可选用RNN或Transformer,模型训练需划分训练集、验证集和测试集,通过交叉验证优化超参数,如学习率、 batch size等,训练过程中需监控模型性能指标,防止过拟合或欠拟合,可采用正则化、Dropout等技术提升模型泛化能力。

模型训练完成后,需进行系统集成与部署,将模型封装为API服务,通过容器化技术(如Docker)实现环境一致性,再通过云平台(如AWS、Azure)或本地服务器部署,部署后需持续监控模型性能,包括预测准确率、延迟等指标,并建立反馈机制,定期用新数据重新训练模型,确保模型适应数据分布变化,需关注模型的可解释性,采用LIME、SHAP等工具分析模型决策依据,增强用户信任。

伦理与安全考量,AI开发需遵循数据隐私保护法规(如GDPR),对敏感数据进行脱敏处理;避免算法偏见,确保训练数据多样性;建立模型安全防护机制,防止对抗样本攻击或数据泄露,需制定应急预案,当模型出现异常时能快速响应和修复。

相关问答FAQs:

Q1: 如何解决AI开发中数据量不足的问题?

A1: 可采用迁移学习,利用预训练模型(如BERT、ResNet)在目标任务上进行微调;或通过数据增强技术生成合成数据,如图像旋转、文本回译;也可采用半监督学习,结合少量标注数据和大量无标签数据训练模型,提升数据利用效率。

Q2: AI模型部署后性能下降怎么办?

A2: 首先通过监控工具定位性能瓶颈,如数据分布偏移、特征变化或模型退化;然后收集新数据对模型进行增量训练或全量重新训练;同时可优化模型结构(如剪枝、量化)提升推理效率;建立A/B测试机制,对比新旧模型效果,确保优化策略有效。