随着互联网技术的飞速发展,数据已成为企业决策的核心驱动力,而爬虫技术作为数据获取的重要手段,在各行各业的应用日益广泛,从电商平台的竞品价格监测,到金融行业的舆情分析,再到科研领域的数据挖掘,爬虫工程师的需求持续攀升,成为当前IT招聘市场的热门岗位之一,爬虫工作招聘不仅要求候选人具备扎实的技术功底,还需要对数据合规性、反爬机制应对等有深刻理解,以下是关于爬虫工作招聘的详细解读。

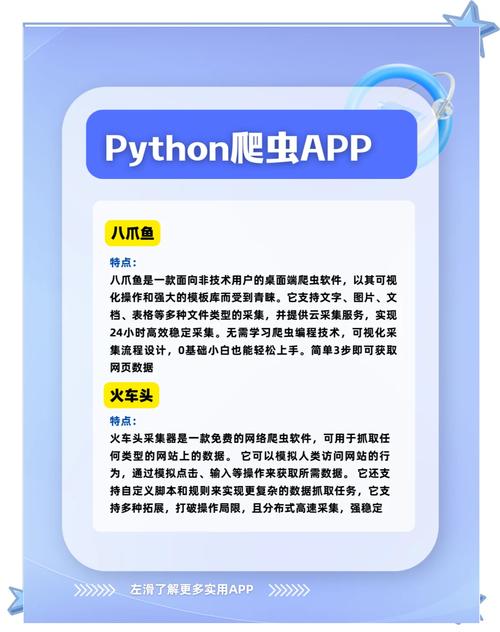

爬虫岗位的核心职责通常包括数据采集、清洗、存储及简单分析的全流程设计,企业招聘时,会根据业务需求细化岗位要求,例如初级爬虫工程师可能侧重基础爬虫框架的使用(如Scrapy、BeautifulSoup),而高级岗位则需精通分布式爬虫架构、动态页面渲染技术(如Selenium、Playwright),甚至涉及IP代理池管理、验证码识别、反反爬策略优化等进阶技能,熟悉Linux环境、Python编程语言、数据库操作(MySQL、MongoDB等)是基本门槛,部分企业还会要求候选人掌握日志分析、异常监控或数据可视化工具,以提升数据处理的效率与价值。

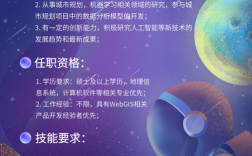

在技能要求方面,企业普遍强调“技术广度”与“深度”的结合,技术广度体现在对多种爬虫框架、数据存储方案及网络协议(HTTP/HTTPS)的熟悉程度,例如需了解TCP/IP模型、Cookie/Session机制、Ajax异步加载原理等,以便精准定位数据接口并高效解析,深度则体现在应对复杂场景的能力,如针对JavaScript动态渲染的页面,需掌握无头浏览器技术;面对高频请求限制,需设计分布式任务队列(如Celery、RabbitMQ)和IP轮换策略;对于结构化数据,需熟练运用正则表达式、XPath或CSS选择器进行提取,数据合规意识也是重要考量,候选人需熟悉《网络安全法》《个人信息保护法》等法规,确保爬取行为合法合规,避免侵犯企业或个人的合法权益。

企业背景与行业差异直接影响爬虫岗位的招聘方向,互联网公司(如电商平台、内容平台)通常需求量大,业务场景复杂,要求候选人具备高并发爬虫开发、反爬对抗经验,甚至熟悉机器学习算法(如通过训练模型识别验证码),金融科技企业则更关注数据的实时性与准确性,需候选人掌握增量爬取、数据去重及异常检测技术,传统行业(如制造业、零售业)的数字化转型催生了大量数据采集需求,岗位可能更侧重业务逻辑理解与跨部门协作,技术门槛相对较低但需快速学习行业知识,科研机构、高校实验室等也会招聘爬虫工程师,用于学术数据采集,此类岗位对算法优化、数据清洗的严谨性要求较高,通常需具备统计学或数据分析基础。

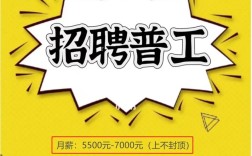

薪资水平方面,爬虫工程师的薪酬受地域、经验、企业规模等多重因素影响,一线城市(如北京、上海、深圳)的初级岗位月薪普遍在8K-15K,中级工程师可达15K-30K,高级或资深岗位(如具备架构设计或反爬专家能力)年薪普遍在30万-60万,部分头部企业或稀缺岗位甚至更高,二三线城市的薪资水平约为一线的70%-80%,但生活成本较低,整体性价比优势明显,值得注意的是,随着数据安全监管趋严,具备合规风险经验的候选人更受企业青睐,薪资溢价明显。

职业发展路径上,爬虫工程师可向“技术专家”或“管理岗”双线发展,技术专家路线聚焦爬虫架构优化、反爬技术研发或数据挖掘方向,进阶为数据工程师、算法工程师;管理岗则可向数据团队负责人、项目经理转型,统筹数据采集项目规划与团队协作,爬虫技术与其他领域的结合(如大数据处理、人工智能)也为职业发展提供了更多可能性,例如转向数据中台建设或智能推荐系统开发。

相关问答FAQs

Q1:爬虫工程师需要掌握哪些核心工具和技术?

A1:核心工具和技术包括:①编程语言:Python(必备,掌握requests、Scrapy、BeautifulSoup等库);②动态页面处理:Selenium、Playwright、Puppeteer等无头浏览器;③数据存储:MySQL、MongoDB、Redis等数据库;④反爬技术:IP代理池(如Tor、付费代理)、验证码识别(如Tesseract OCR、第三方打码平台)、User-Agent池管理;⑤分布式架构:Celery、Scrapy-Redis、Docker容器化部署;⑥基础工具:Linux命令行、Git版本控制、正则表达式/XPath,了解HTTP协议、TCP/IP模型及数据合规法规(如《个人信息保护法》)也是必备知识。

Q2:如何应对企业面试中的反爬策略相关问题?

A2:面试中反爬策略的应对需结合实际场景:①高频请求限制:可通过IP代理轮换、请求频率控制(如随机延时、令牌桶算法)、分布式爬虫降低单IP压力;②动态加密:分析JavaScript渲染逻辑,使用无头浏览器模拟真实用户行为,或通过逆向工程获取加密参数;③验证码:简单验证码可使用OCR识别,复杂验证码(如reCAPTCHA)需结合第三方打码平台或人工打码;④文本混淆:针对动态加载或加密文本,可通过分析接口请求(如浏览器F12开发者工具)直接获取API数据,或使用Selenium模拟页面渲染后提取,回答时需强调“合法合规”原则,避免提及恶意爬取或绕过企业安全机制的行为。