是许多开发者和系统管理员日常工作中常用的操作,它可以帮助我们快速获取网页源码、检查接口响应、抓取特定数据等,在命令行环境中,有多种工具可以实现这一功能,每种工具都有其独特的优势和适用场景,本文将详细介绍几种常用的命令行工具及其使用方法,包括它们的特点、基本语法、高级选项以及实际应用案例。

最常用的工具之一是curl。curl是一个功能强大的命令行工具,支持多种协议(如HTTP、HTTPS、FTP、SMTP等),可以轻松发送请求并获取响应,它的基本语法非常简单,例如使用curl https://www.example.com即可获取网页的HTML内容。curl的优势在于其灵活性和丰富的选项,比如可以通过-L参数跟随重定向,-A参数设置User-Agent,-H参数添加自定义请求头,-d参数发送POST数据等。curl还支持断点续传、代理设置、SSL证书验证等高级功能,使其成为处理复杂网络请求的首选工具,模拟浏览器访问并保存Cookies可以使用curl -c cookies.txt -b cookies.txt -L "https://example.com/login",而下载大文件时则可以通过curl -O -C - https://example.com/largefile.zip实现断点续传。

另一个常用的工具是wget。wget最初设计用于非交互式下载文件,但也支持获取网页内容,与curl相比,wget在下载文件时更加便捷,例如使用wget -q -O - https://example.com可以静默输出网页内容到标准输出。wget的亮点在于其递归下载功能,可以通过-r参数递归下载整个网站,并通过-l参数限制递归深度。wget支持镜像网站(-m参数)、限制下载速率(--limit-rate)、排除特定文件(-R参数)等特性,非常适合网站爬取和离线浏览,完整镜像一个网站可以使用wget --mirror --convert-links --adjust-extension --page-requisites --no-parent https://example.com,其中--convert-links会转换链接以便离线浏览,--page-requisites会下载所有依赖资源(如CSS、JS)。

除了curl和wget,还有一些更专业的工具适用于特定场景。httpie是一个比curl更友好的HTTP客户端,其语法更接近自然语言,例如使用http GET https://example.com即可发送GET请求,http POST https://example.com name='John' age=30可以发送JSON格式的POST请求。httpie支持自动语法高亮、会话管理、JSON格式化等功能,适合需要频繁调试API的开发者。lynx和w3m是纯文本浏览器,它们可以将网页内容转换为纯文本显示,非常适合在终端中快速浏览网页内容,例如使用lynx https://example.com会以文本形式展示网页结构,忽略图片和样式。

在选择工具时,需要根据具体需求进行权衡,如果只是简单获取网页内容,curl和wget都能满足需求;如果需要处理复杂的HTTP请求(如认证、自定义头),curl更为灵活;如果需要递归下载或镜像网站,wget是更好的选择;如果需要友好的API调试体验,httpie则更为便捷,以下是一个简单的对比表格,帮助快速理解不同工具的特点:

| 工具名称 | 主要用途 | 优势 | 常用参数示例 |

|---|---|---|---|

| curl | HTTP请求、文件下载 | 协议支持多、选项丰富 | curl -L -H "X-Custom: value" -d "data" https://example.com |

| wget | 文件下载、网站镜像 | 递归下载、离线浏览支持 | wget -r -l 2 -A pdf https://example.com |

| httpie | API调试、HTTP请求 | 语法友好、自动格式化 | http POST https://example.com name='John' |

| lynx | 纯文本浏览 | 无需图形界面、快速查看 | lynx -dump https://example.com |

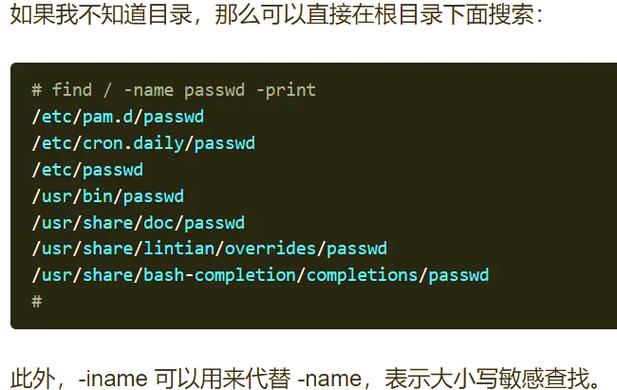

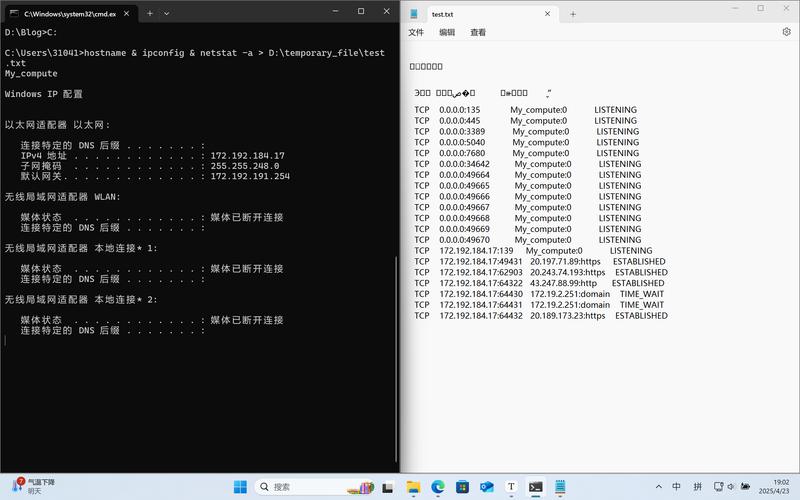

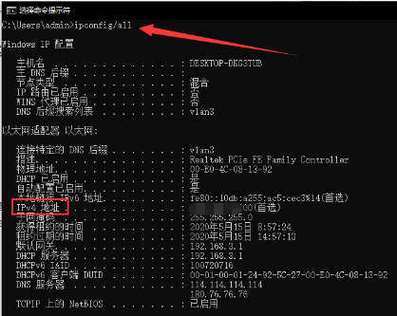

在实际应用中,命令行获取网页内容可以结合其他命令实现更复杂的功能,使用curl获取网页后,通过grep提取特定信息,sed进行文本替换,或awk进行数据处理,获取网页标题可以使用curl -s https://example.com | grep -oP '<title>\K.*?(?=</title>)',其中-s参数用于静默模式,避免显示进度信息,可以将命令行工具与脚本结合,实现自动化任务,例如使用while循环定时获取网页内容并监控变化,或通过cron设置定时任务。

需要注意的是,在使用命令行工具获取网页内容时,应遵守网站的robots.txt规则和法律法规,避免对服务器造成过大压力或侵犯版权,部分网站可能会限制命令行工具的访问,此时可以通过设置合理的请求间隔、使用代理或添加随机User-Agent来降低被屏蔽的风险,使用curl添加随机User-Agent可以使用curl -H "User-Agent: $(shuf -n 1 useragents.txt)" https://example.com,其中useragents.txt包含多个User-Agent字符串。

相关问答FAQs:

-

问题:curl和wget有什么区别?如何选择?

解答:curl和wget的主要区别在于设计目标和功能侧重,curl最初是一个客户端工具,支持多种协议,适合发送复杂的HTTP请求(如自定义头、认证、POST数据等);而wget主要用于文件下载和网站镜像,支持递归下载、断点续传和离线浏览,如果需要调试API或发送非GET请求,curl更合适;如果需要下载整个网站或大量文件,wget更高效,curl支持流式输出,可以实时处理数据,而wget默认会先下载到本地再处理。 (图片来源网络,侵删)

(图片来源网络,侵删) -

问题:如何避免被网站屏蔽命令行请求?

解答:为了避免被网站屏蔽,可以采取以下措施:1)设置合理的请求间隔,例如使用sleep命令在两次请求间添加延迟;2)添加随机的User-Agent,避免使用默认的curl/wget标识;3)使用代理IP分散请求来源;4)遵守网站的robots.txt规则,不爬取禁止访问的路径;5)限制请求频率,避免短时间内发送大量请求,使用curl时可以通过--limit-rate参数限制下载速率,或--random-file添加随机性。