制作网页搜索引擎是一个涉及多个技术环节的复杂过程,需要结合前端界面设计、后端数据处理、算法优化以及服务器部署等技术,以下将从需求分析、技术选型、数据爬取、索引构建、搜索实现到系统优化等环节,详细拆解网页搜索引擎的制作步骤。

需求分析与技术选型

在开始制作前,需明确搜索引擎的核心目标:支持关键词搜索、返回相关结果、具备一定的实时性,根据需求规模选择技术栈:小型项目可采用Python + Flask/Django框架,搭配SQLite或MySQL数据库;中大型项目需引入分布式技术,如Elasticsearch或Solr,配合Scrapy或分布式爬虫框架(如Apache Nutch),前端界面可使用React或Vue.js构建动态交互页面,后端则通过RESTful API提供数据支持。

网页爬虫设计与实现

爬虫是搜索引擎的数据采集端,需实现以下功能:

- URL管理:使用优先队列存储待抓取URL,通过Bloom Filter过滤重复链接,避免重复爬取,可通过Redis实现分布式URL调度,提升大规模爬取效率。

- 页面解析:采用BeautifulSoup(Python)或Jsoup(Java)解析HTML,提取标题、正文、关键词等元数据,对于动态加载页面,需结合Selenium或Playwright模拟浏览器行为。

- 反爬策略:设置User-Agent轮换、IP代理池(如Tor或付费代理),控制爬取频率(如随机延时),并遵守robots.txt协议,避免对目标网站造成压力。

以下为爬虫核心逻辑的伪代码示例:

def crawl(url):

if url not in visited_urls:

html = fetch_html(url) # 发送HTTP请求

data = parse_html(html) # 解析页面内容

save_to_database(data) # 存储数据

for link in extract_links(html): # 提取新链接

if is_valid(link):

add_to_queue(link)

数据预处理与索引构建

原始网页数据需经过清洗和结构化处理,才能高效支持搜索:

- 文本清洗:去除HTML标签、JavaScript代码、停用词(如“的”“是”),通过TF-IDF或TextRank算法提取关键词。

- 分词处理:中文需使用Jieba或HanLP进行分词,英文可采用NLTK或spaCy,确保搜索能匹配到词根(如“running”匹配“run”)。

- 索引构建:倒排索引是核心结构,记录关键词与文档ID的映射关系。 | 关键词 | 文档ID列表 | |--------|------------| | 人工智能 | [1, 3, 5] | | 搜索引擎 | [2, 3, 7] |

Elasticsearch通过Lucene引擎提供分布式索引能力,支持增量更新和实时检索,适合大规模数据场景,索引时需设置字段类型(如text、keyword)、分词器(如IK分词器)以及权重 boosting策略,提升核心关键词的相关性。

搜索功能实现

搜索模块需处理用户查询、匹配索引并返回排序结果:

- 查询解析:对用户输入进行分词、纠错(如使用拼音或模糊匹配)和查询扩展(如同义词替换)。

- 结果排序:结合BM25算法(TF-IDF的改进版)、PageRank(网页权威性)以及用户行为数据(如点击率、停留时间)计算相关性得分。

相关性得分 = 0.4 * BM25 + 0.3 * PageRank + 0.3 * 用户行为权重 - 分页与高亮:实现分页逻辑(如基于游标的分页提升性能),并将关键词在结果中高亮显示,提升用户体验。

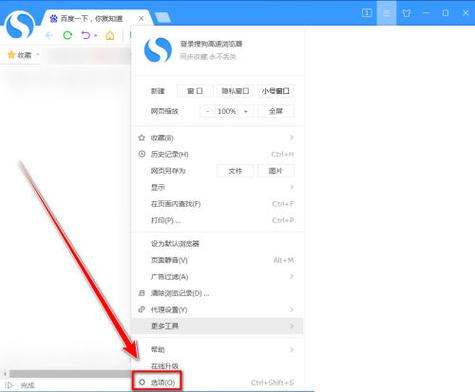

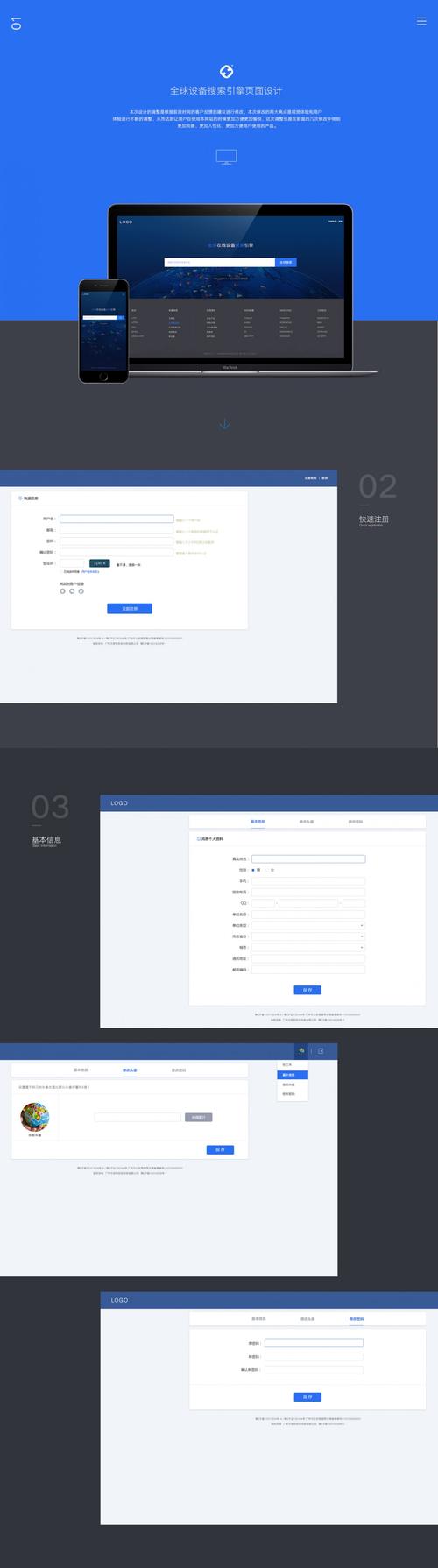

前端界面与交互设计

前端需提供简洁的搜索框和结果展示页面:

- 搜索框:支持输入联想(通过AJAX请求后端API)和搜索建议(如热门搜索词)。

- 结果列表、URL、包含高亮关键词)及缓存快照。

- 性能优化:采用懒加载、CDN加速静态资源,并通过WebSocket实现实时搜索结果更新。

系统优化与维护

- 性能优化:通过缓存(如Redis存储热门查询结果)、索引分片(按时间或类别拆分索引)和异步处理(如消息队列Kafka解耦爬取与搜索模块)提升响应速度。

- 监控与日志:使用ELK(Elasticsearch + Logstash + Kibana)收集系统日志,监控爬虫健康度、索引大小和查询延迟。

- 反作弊机制:识别恶意爬虫(如通过请求频率分析)和垃圾网页(如基于内容重复率或用户举报过滤)。

部署与扩展

- 容器化部署:使用Docker封装爬虫、搜索和前端服务,通过Kubernetes实现自动扩缩容。

- 分布式架构:若数据量达到TB级,可采用Hadoop存储原始数据,Spark进行批量处理,Elasticsearch提供实时检索。

相关问答FAQs

Q1: 如何解决中文分词的歧义问题?

A1: 中文分词需结合词典匹配和统计模型,使用Jieba的HMM模型处理未登录词,通过自定义词典(如专业术语)修正分词结果;对于歧义场景(如“发展中国家”可能被切分为“发展/中国/家”),可采用基于上下文的CRF(条件随机场)模型或深度学习模型(如BERT)进行语义理解,提升分词准确性。

Q2: 如何提升搜索结果的实时性?

A2: 实时性需从数据更新和索引刷新两方面优化:1)爬虫采用增量抓取策略,仅爬取变更页面(通过Last-Modified头或网站RSS feed);2)索引构建使用“索引段合并”机制,如Elasticsearch的Near Real-Time (NRT)功能,确保数据在秒级内可见;3)对高热度页面(如新闻)建立独立实时索引,通过流处理框架(如Flink)实时更新数据。